Online Hadoop Test – Einstellungstest zur Bewerbervorauswahl

Worum geht es in dem Test?

Dieser Hadoop-Test bewertet das Verständnis und die Erfahrung der Kandidaten mit dem Hadoop-Framework, seinen Kernkomponenten und den Best Practices für die Verarbeitung großer Datenmengen.

Abgedeckte Fähigkeiten

Testersteller

Tim Funke

Softwareentwickler bei der Telekom

Mit einer achtjährigen Tätigkeit bei der Deutschen Telekom hat Tim Funke nicht nur seine Fähigkeiten als Softwareentwickler unter Beweis gestellt, sondern sich auch als DevOps- und Dateningenieur hervorgetan. Er beherrscht Technologien wie Python, Docker und GitLab und ist spezialisiert auf objektorientierte Programmierung (OOP), Qualitätssicherung und kontinuierliche Integration und Auslieferung (CI/CD). Tims Kenntnisse in verschiedenen Programmiersprachen wie VBA und Go verdeutlichen die Breite seiner technischen Fähigkeiten.

Wer sollte diesen Test machen?

Big Data-Ingenieur, Hadoop-Administrator, Hadoop-Entwickler, Hadoop-Tester, Softwareentwickler, Spark-Entwickler

Beschreibung

Hadoop ist ein bedeutendes Framework für die Verarbeitung, Speicherung und Analyse großer Datenmengen und hilft Unternehmen dabei, Einblicke zu gewinnen und datengetriebene Entscheidungen effektiver zu treffen. Es ist darauf ausgelegt, eine Mischung aus komplexen und strukturierten Daten in einer verteilten Rechenumgebung zu verarbeiten, was es zu einem entscheidenden Werkzeug für jede datengetriebene Rolle macht.

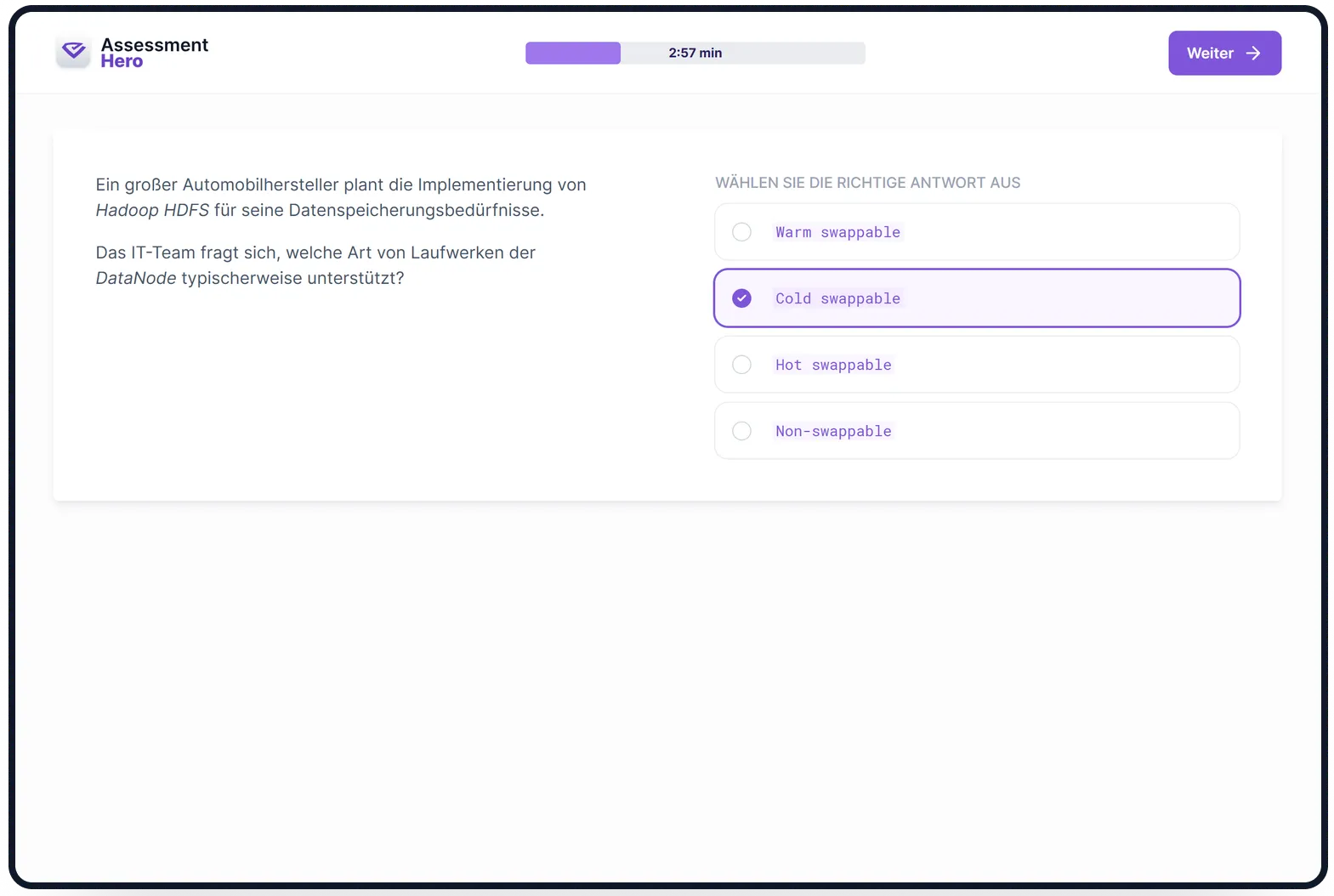

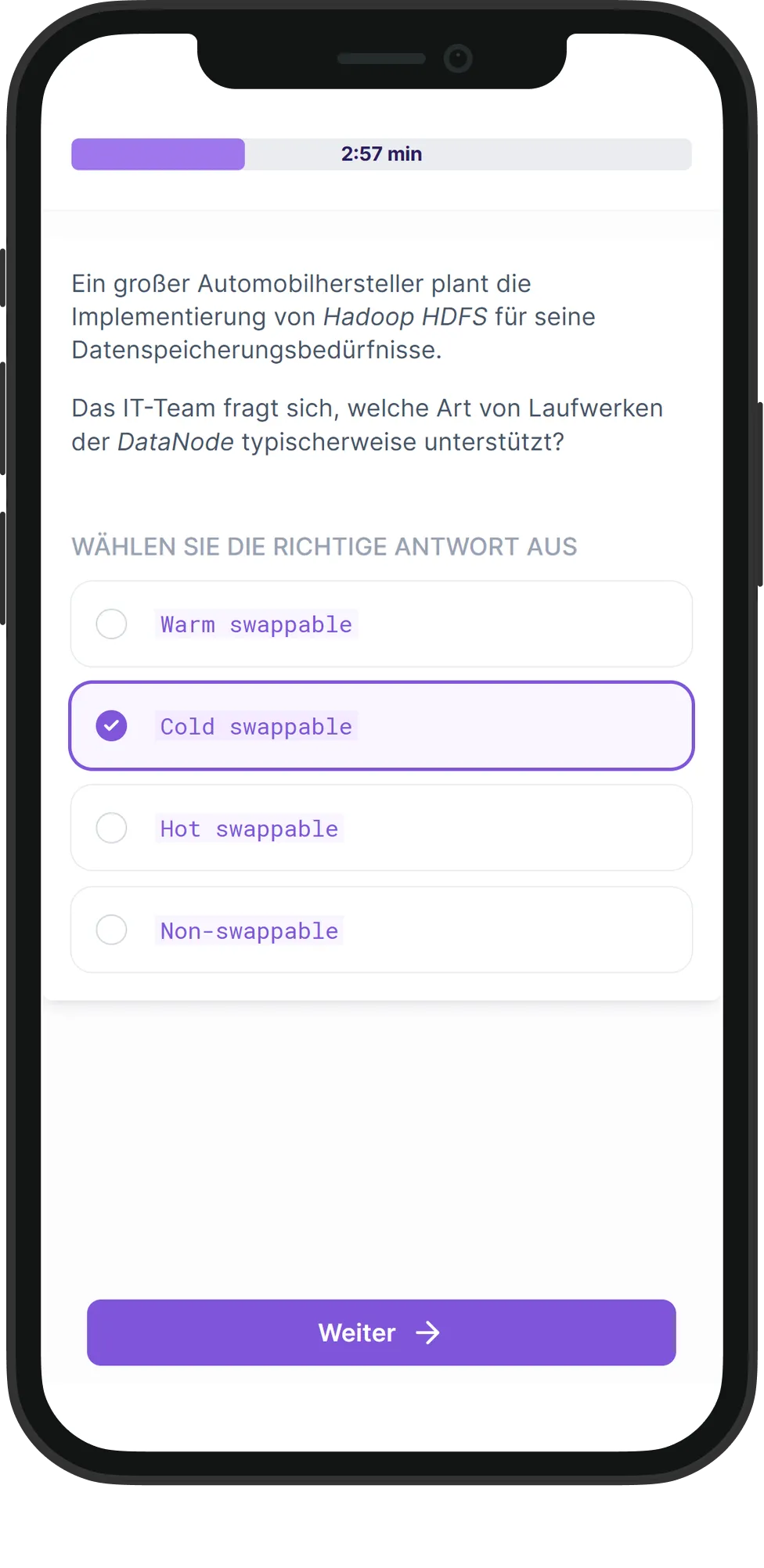

Dieser Test bewertet die Fähigkeiten und das Wissen der Kandidaten rund um das Kern-Hadoop-Framework, einschließlich Bereichen wie HDFS, MapReduce, Hadoop-Ökosystemkomponenten (wie Hive und Pig) und der Optimierung von Datenverarbeitungsaufgaben. Diese Bewertung soll einen Einblick in das Verständnis des Kandidaten sowohl in Bezug auf die Verarbeitung großer Datensätze als auch auf das Management verteilter Rechenaufgaben geben.

Kandidaten, die gut in Hadoop sind, sind in der Lage, leistungsstarke, skalierbare und robuste Lösungen für große Datenmengen für Ihre Organisation zu entwerfen und zu implementieren. Wenn sie in diesem Test hervorragend abschneiden, haben sie ihre Fähigkeit unter Beweis gestellt, mit großen Datenlasten umzugehen, Datenabfragen zu optimieren und zum datengesteuerten Entscheidungsprozess einer Organisation beizutragen.

Dieser Test bewertet die Fähigkeiten und das Wissen der Kandidaten rund um das Kern-Hadoop-Framework, einschließlich Bereichen wie HDFS, MapReduce, Hadoop-Ökosystemkomponenten (wie Hive und Pig) und der Optimierung von Datenverarbeitungsaufgaben. Diese Bewertung soll einen Einblick in das Verständnis des Kandidaten sowohl in Bezug auf die Verarbeitung großer Datensätze als auch auf das Management verteilter Rechenaufgaben geben.

Kandidaten, die gut in Hadoop sind, sind in der Lage, leistungsstarke, skalierbare und robuste Lösungen für große Datenmengen für Ihre Organisation zu entwerfen und zu implementieren. Wenn sie in diesem Test hervorragend abschneiden, haben sie ihre Fähigkeit unter Beweis gestellt, mit großen Datenlasten umzugehen, Datenabfragen zu optimieren und zum datengesteuerten Entscheidungsprozess einer Organisation beizutragen.

Überblick

Testersteller

Tim Funke

Softwareentwickler bei der Telekom

Mit einer achtjährigen Tätigkeit bei der Deutschen Telekom hat Tim Funke nicht nur seine Fähigkeiten als Softwareentwickler unter Beweis gestellt, sondern sich auch als DevOps- und Dateningenieur hervorgetan. Er beherrscht Technologien wie Python, Docker und GitLab und ist spezialisiert auf objektorientierte Programmierung (OOP), Qualitätssicherung und kontinuierliche Integration und Auslieferung (CI/CD). Tims Kenntnisse in verschiedenen Programmiersprachen wie VBA und Go verdeutlichen die Breite seiner technischen Fähigkeiten.